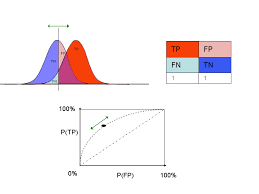

La curva de las características del operador receptor (ROC) y el área bajo la curva (AUC) están relacionadas con la matriz de confusión para evaluar el rendimiento del modelo de clasificación.

La forma ideal de la curva ROC se encuentra en la parte superior izquierda del gráfico TPR vs FPR. Cuando hay superposición de clases, habrá una introducción de error tipo 1 y tipo 2. La manipulación del umbral se utiliza para minimizar o maximizar cualquiera de esos tipos de errores.

Los modelos con valores de AUC iguales a uno son ideales y significa que la separabilidad del modelo de clasificación es 100% para que no haya superposición de clasificadores y el modelo pueda identificarse claramente entre clasificadores (tener enfermedad, no enfermedad o sí / no). Por otro lado, un AUC con valor cero indica que no hay separabilidad lo suficientemente clara como para confirmar que los resultados son correctos (la clasificación es recíproca, sí es no y no es sí, esto conduce a malos resultados).

AUC igual a 0.5 significa que el rendimiento del modelo no tiene la posibilidad de clasificarlo lo suficientemente bien como para que los resultados no sean lo suficientemente confiables. AUC = 0.7 significa que hay un 70% de posibilidades de que el modelo pueda distinguir adecuadamente las clases negativas y positivas.

Área bajo la curva Curva de recuperación de precisión (AUC-PR) Curva